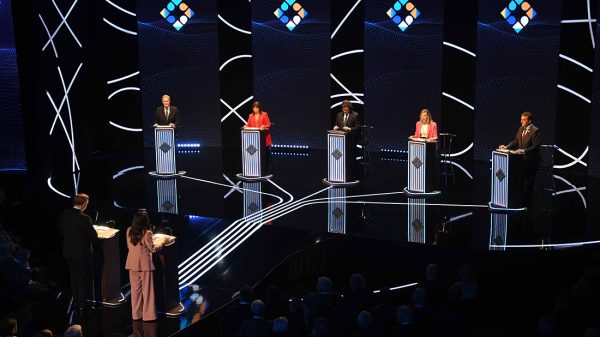

Audiovideojuego que puede ser utilizado para el entrenamiento de habilidades espaciales de personas con discapacidad visual. Foto: Gentileza de Martina Faux / CONICET.

Una habitación completamente oscura y un juego electrónico sin imágenes visuales. Los participantes sólo reciben sonidos y en base a ellos deben guiar su acción: recorren pasillos, abren puertas, recogen monedas y aprenden a ignorar ruidos de fondo para no distraerse del objetivo. Es un audiojuego desarrollado por un grupo de investigadores cordobeses para realizar sus estudios acerca de la percepción y que puede ser utilizado para el entrenamiento de habilidades espaciales de personas con discapacidad visual. Además puede favorecer la integración, ya que es entretenido y desafiante tanto para ciegos como para personas con visión normal.

Claudia Arias, profesora para ciegos e investigadora independiente en el CONICET, dirige un equipo de psicólogos, profesores de educación especial e ingenieros que funciona en el Centro de Investigación y Transferencia en Acústica (CINTRA), unidad asociada del CONICET con sede en la Universidad Tecnológica Regional Córdoba. “El objetivo es estudiar la percepción sin usar la visión para realizar aportes en los programas de entrenamiento de habilidades básicas de Orientación y Movilidad de la persona ciega”, explica la científica.

Como parte de esta investigación surgió la tesis de doctorado de Fernando Bermejo, becario posdoctoral del CONICET en el CINTRA. “Consistió en estudiar cómo emergen estas reglas de percepción, cómo desde cero una persona aprende a percibir. Para poder estudiar esto empleamos audiojuegos donde se pueden desarrollar estas habilidades”, describe Fernando Bermejo, becario posdoctoral del CONICET en el CINTRA.

Estudiar estos procesos adaptativos es muy difícil porque una vez que se adquieren estas reglas, se convierten en comportamientos automáticos. “Una persona ciega o una persona con visión normal jugando a oscuras por primera vez con un audiojuego constituyen modelos paradigmáticos que brindan una excelente oportunidad para estudiar cómo ocurre el proceso de aprendizaje sensoriomotor sin usar la visión”, explica Claudia Arias.

En los estudios participaron personas ciegas con buena movilidad independiente y personas con visión normal. Cada jugador, valiéndose de un joystick y orientándose sólo por sonidos espacializados mediante un sistema de sonido envolvente, debía avanzar a través de un laberinto para juntar la mayor cantidad posible de monedas sólo guiado por pistas sonoras: pasos, puertas y monedas que caen. Se jugó con dos niveles de dificultad: con entorno sonoro calmo (brisas) y con entorno ruidoso (fiesta) y el rendimiento se midió según la cantidad de errores cometidos y el tiempo que demoró en completar el recorrido.

“Todos los participantes cumplieron la consigna y lograron reconocer posteriormente el camino recorrido pero las personas ciegas tendieron a cometer menos errores y a tardar menos en llegar al final del recorrido. Estas diferencias tuvieron una importancia estadística en el nivel más difícil, esto es, en entorno ruidoso de una fiesta” explica Bermejo.

Para realizar parte de las investigaciones, el grupo se valió de una tecnología ya existente, los audiojuegos, que adaptó a sus propias necesidades basándose en los nuevos enfoques teóricos de cognición corporizada. Los modelos resultantes fueron a su vez aplicados para mejorar las interfaces de los juegos y también para diseñar robots que puedan aprender el mundo que los rodea. De esta manera, existe una constante interacción y retroalimentación entre acústica, psicología, ingeniería electrónica, robótica y computación.

COGNICIÓN CORPORIZADA

Los investigadores estudian fenómenos de audio percepción- acción sin usar la visión a partir de una línea teórica y pone el acento en la percepción como acción y en el sonido como evento en relación a la fuente y al contexto, no como mera vibración.

Este enfoque, llamado enactivo, es un cambio radical respecto a concepciones tradicionales de la percepción que la entendían solamente como un producto de la fisiología: cerebro, oídos, ojos. “Sostiene que la percepción se constituye a partir de reglas o patrones específicos de acoplamiento que ocurren entre la acción realizada por el agente y el cambio subsecuente que se produce en sus sensaciones”, explica Arias.

AUDIOJUEGOS ENACTIVOS

El primer audiojuego fue adaptado por Guillermo Gilberto. A partir de esa experiencia el equipo pudo ver que esta área -de vacancia nacional e internacional-, es muy potente como herramienta de entretenimiento que sirve a su vez para el entrenamiento de habilidades perceptuales. Y hacia ese horizonte comenzaron a proyectarse los sucesivos trabajos que confluyeron en el proyecto doctoral de Gilberto, cuyo objetivo es el desarrollo de la plataforma enactiva de audiojuegos formativos para personas con y sin discapacidad visual, BÚHO-ie.

“En un primer momento hicimos las adaptaciones que necesitábamos para la investigación. Pasamos de un juego centrado en una computadora, con auriculares y teclado a otro dispositivo con parlantes distribuidos, con un joystick que vibraba y tenía más riqueza en estímulos. Después comencé a desarrollar un audiojuego con sonido envolvente donde el usuario tiene libre movilidad, un puntero y sensores en los parlantes que identifican la señal del puntero”, explica Gilberto.

La idea de que el juego implique el uso del cuerpo concuerda con la noción de que el conocimiento del entorno es sensoriomotor, donde la persona modula sus movimientos para poder percibir mejor. “Sólo a medida que el jugador va haciendo aprende nuevas cosas, y esto hace que los aprendizajes se incorporen de tal manera que se hacen carne, como andar en bicicleta: uno no se olvida porque ese saber se hizo cuerpo”, explica Guillermo.

La plataforma BÚHO-ie, funciona como herramienta de integración ya que es atractivo tanto para personas con y sin visión normal y puede ser jugado por más de una a la vez. Además constituye un ambiente nuevo para ambas y pone en juego sus capacidades en igualdad de condiciones.

UN ROBOT QUE APRENDE

La tercera línea del equipo tiene que ver con la robótica sustentada en perspectivas enactivas y está logrando promisorios avances en relación a la autonomía y adaptación de los robot en interacción con otros agentes situados en ambientes reales. “Uno de los desafíos centrales consiste en el desarrollo de modelos de control que materialicen el acoplamiento sensoriomotor exitoso en relación con el medio. Ello implica el desarrollo de una nueva arquitectura computacional específicamente concebida para implementar las dinámicas observadas en las investigaciones que realizamos en humanos”, explica Valentín Lunati, becario del CONICET.

“La idea es entablar un diálogo con las teorías enactivas para que el robot pueda aprender a percibir, que no sea totalmente programado sino que pueda ir adquiriendo nuevas habilidades”, agrega el becario. En la actualidad los robots pueden realizar funciones muy complejas como jugar al ajedrez pero tienen dificultades con tareas más simples como diferenciar sonidos o darse vuelta si caen boca arriba. La información que se obtiene en los estudios con personas puede alimentar los modelos computacionales para solucionar este tipo de problemas y mejorar su interacción con el entorno a través de capacidades bioinspiradas.

“Esto sería muy útil para robots que trabajan en la oscuridad, en condiciones cambiantes y peligrosas, como el rescate de personas donde la visión no sirve y son necesarias capacidades auditivas más complejas. Por otro lado, permite probar si estos modelos que construimos sirven para que un robot efectué las mismas tareas que realizan las personas, por lo que además, sería un método de validación de los postulados construidos, produciendo una retroalimentación entre teoría y experimentación”, concluye Lunati.

Para ver trabajo de referencia hacer click aquí.

Sumate al equipo y ayudanos a contar más historias.

Cómo comunicarse:

Redacción: [email protected]

Lectores: [email protected]

Equipo de Investigación: [email protected]